Les centres de données, « cloud » inclus, stockent les mégadonnées (big data) numériques de l’humanité sur disques durs et bandes magnétiques dont la durée de vie limitée oblige à de dispendieuses recopies tous les cinq à sept ans ; ils représentent des « gouffres » pour les ressources en terrain, électricité, eau et matériaux rares. En comparaison, le stockage à l’échelle moléculaire sur un polymère tel que l’ADN, permettrait une densité supérieure d’un facteur dix mil- lions, une conservation prolongée d’un facteur dix mille sans recopie périodique, pour une consommation électrique quasi-nulle. En effet, l’ADN est stable à température ordinaire durant plusieurs millénaires et il peut être aisément dupliqué ou volontairement détruit. Les technologies requises existent. Cependant, pour devenir viables pour l’archivage de l’information, ces technologies nécessitent encore des progrès qui pourraient voir le jour sous cinq à vingt ans et seraient favorisés par des synergies entre secteurs public et privé.

Le stockage et archivage des mégadonnées numériques (« big data », le carburant de l’intelligence artificielle) par l’approche actuelle des centres de données ne sera pas soutenable au-delà de 2040. Il est donc urgent de focaliser des efforts soutenus en recherche et développement (R&D) pour l’avènement d’approches alternatives, dont aucune n’est présentement assez mature.

La sphère globale des données (SGD) créées par l’humanité était estimée en 2018 à trente-trois mille milliards de milliards de caractères (« octets »), du même ordre que le nombre estimé de grains de sable sur terre. Ces données proviennent de la recherche et de l’industrie, mais aussi de nos connexions amicales et professionnelles, livres, vidéos et photos, informations médicales ; sans oublier dans le futur voitures autonomes, capteurs, télésurveillance, réalité virtuelle, diagnostic et chirurgie à distance. La SGD augmente d’un facteur environ mille tous les vingt ans.

Une part majoritaire de ces données est ensuite stockée dans plusieurs millions de centres de données (en incluant ceux des entreprises et le « cloud »), qui fonctionnent au sein de réseaux de transmission. Ensemble , ceux-ci consomment déjà environ 2 % de l’électricité dans les pays avancés. Leur coût de construction et exploitation est globalement de l’ordre de mille milliards d’euros. Ces centres couvrent un millionième de la surface émergée du globe ; au rythme actuel, ils couvriraient un millième vers 2040.

Les technologies de stockage utilisées par ces centres sont rapidement frappées d’obsolescence aux plans du format, du dispositif de lecture/écriture, et aussi du support, lequel nécessite des copies tous les cinq à sept ans pour garantir l’intégrité des données. Elles posent aussi des problèmes croissants d’approvisionnement en ressources rares comme le silicium de qualité électronique.

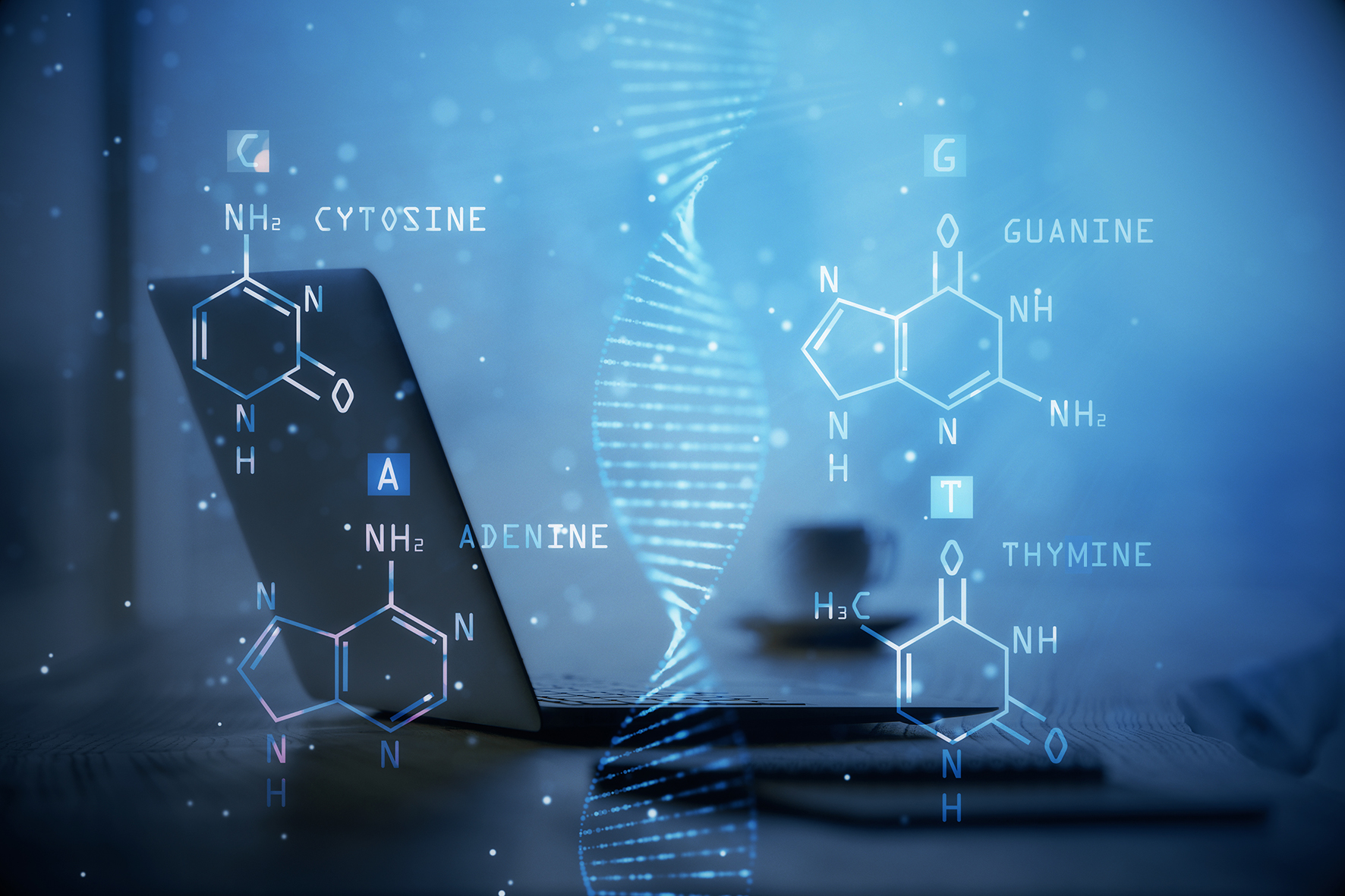

Une alternative prometteuse est offerte par les supports moléculaires porteurs d’information, tel que l’ADN utilisé ici comme agent chimique en dehors du vivant, ou d’autres hétéropolymères non-ADN très prometteurs. Potentiellement, l’ADN permet des densités informationnelles dix millions de fois supérieures aux mémoires traditionnelles : toute la SGD actuelle tiendrait dans une fourgonnette. L’ADN est stable à température ordinaire durant plusieurs millénaires, sans consommation énergétique. Il peut être aisément multiplié ou détruit à volonté. Certains calculs peuvent être physiquement implémentés avec des fragments d’ADN. Enfin, sa technologie ne deviendra pas obsolète car il constitue notre matériel héréditaire.

Pour archiver et retrouver des données dans l’ADN, il convient d’enchaîner cinq étapes : coder le fichier de données binaires dans l’alphabet de l’ADN qui possède quatre lettres, puis écrire, stocker, lire l’ADN et, enfin, décoder l’information lue. Un prototype réalisant ces opérations fonctionne depuis mars 2019 chez Microsoft aux États-Unis. Actuellement, plusieurs ordres de grandeur manquent pour atteindre la viabilité économique de cette approche : un facteur environ mille pour le coût et la vitesse de lecture , et cent millions pour ceux d’écriture. Ces facteurs peuvent sembler faramineux. Ce serait oublier la célérité des progrès des technologies ADN, proches d’un facteur mille tous les cinq ans, donc bien plus rapides que dans les domaines électronique et informatique.

Le rapport se termine par une réflexion prospective qui permet au lecteur de se faire une opinion en quelques pages sur les perspectives techniques, économiques et nationales sur la piste ADN pour archiver les mégadonnées.